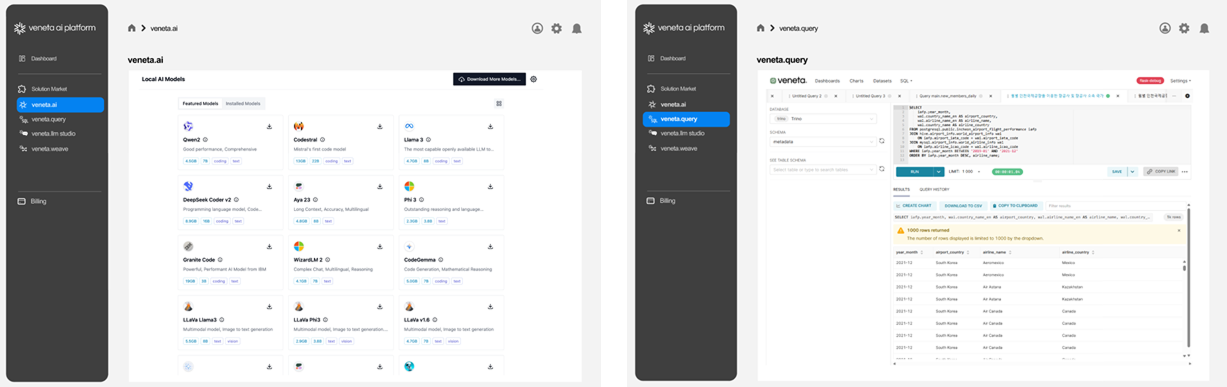

UWS 개발한 AI 솔루션

VENETA AI 플랫폼으로 비즈니스 혁신을 이끄는 AI 서비스를 제공합니다

veneta.lake

veneta.lake은 UWS 개발한 Trino 기반의 고성능 AI 데이터 분석 플랫폼으로, 다양한 데이터 소스를 통합하여 실시간 분석 및 AI 워크로드 최적화를 지원합니다. 기업은 데이터 이동 없이 데이터 레이크, 웨어하우스, 온프레미스, 클라우드 환경을 하나의 인터페이스에서 연결하여 분석할 수 있습니다.

고성능 데이터 분석 및 AI 플랫폼

고성능 SQL 분석

고성능 SQL 분석

고성능 SQL 분석 (Trino 기반 엔진)으로 MySQL, PostgreSQL, Hadoop, S3, Snowflake 등 다양한 데이터 소스 연결을 지원합니다

고속의 데이터 병렬 처리

고속의 데이터 병렬 처리

MPP(Massively Parallel Processing) 아키텍처를 활용하여 데이터 병렬 처리 및 분석 속도의 최적화를 지원합니다

AI 기반 데이터 분석 지원

AI 기반 데이터 분석 지원

OpenAI, Mistral, Azure OpenAI, Google Gemini, LLaMA등 퍼블릭 및 프라이빗 LLM(대규모 언어 모델)과 연계하여 AI 기반 데이터 분석을 지원합니다

데이터 시각화

데이터 시각화

BI 및 AI LLM 기반 대시보드를 통해 데이터 시각화 및 AI 기반 인사이트를 제공합니다

LangChain 지원

LangChain 지원

LangChain 애플리케이션을 쉽게 개발할 수 있는 시각화 프레임워크를 지원합니다

기업용 스택과 연계 지원

기업용 스택과 연계 지원

Cohesity Gaia, IBM Watsonx, CP4D, Veritas NBU/NSS, IBM Diamondback, IBM Ceph 등 기업용 AI & 솔루션 스택과의 연계를 지원합니다

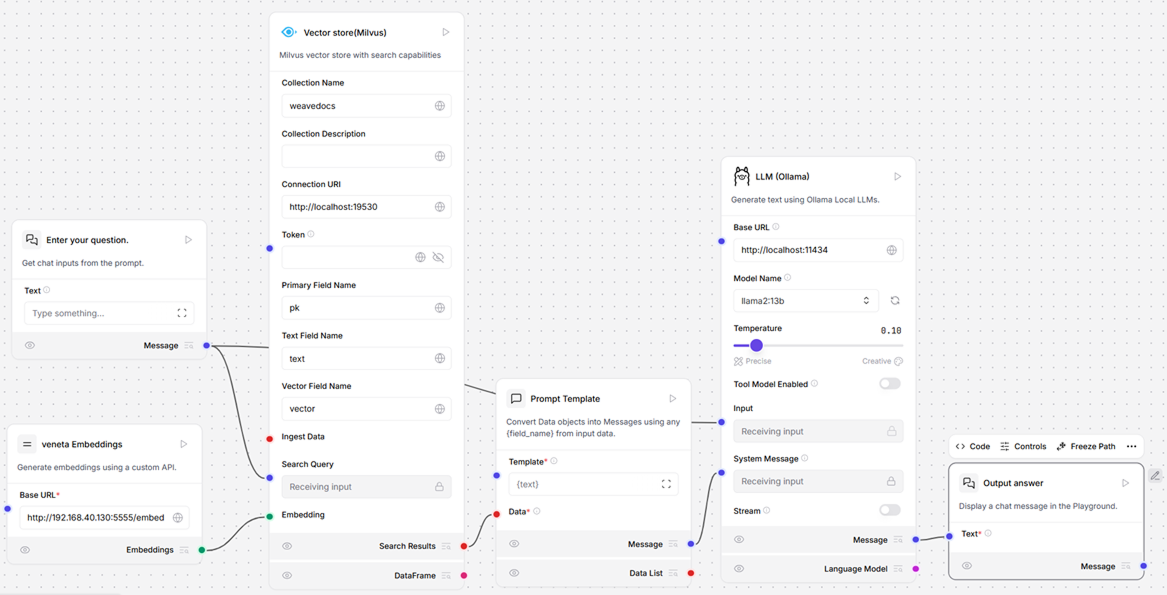

veneta.weave

veneta.lake은 UWS 개발한 대형언어모델(LLM) 기반 애플리케이션으로 누구나 손쉽게 설계하고 배포할 수 있도록 돕는 오픈소스 시각화 개발 도구입니다. 복잡한 코드 없이도 마치 노코드 툴처럼 직관적으로 워크플로우를 구성할 수 있으며, LangChain의 핵심 기능과 완벽히 호환됩니다.

LLM 애플리케이션을 위한 비주얼 프롬프트 & 플로우 설계 툴

드래그 앤 드롭 인터페이스

드래그 앤 드롭 인터페이스

프로그래밍 지식이 없어도 시각적으로 블록을 연결하며 LLM 파이프라인을 구성할 수 있어, 빠른 프로토타이핑 및 테스트가 가능합니다

LangChain 기반 아키텍처

LangChain 기반 아키텍처

문서 검색(RAG), 체인 구성, 에이전트 설정 등 LangChain의 기능을 그대로 시각화하여 구성할 수 있으며, Python 코드로도 내보내기 가능해 유연한 개발이 가능합니다

RAG 구성 최적화

RAG 구성 최적화

PDF, 웹페이지, 데이터베이스 등 다양한 외부 지식 소스와 LLM을 연동해 Retrieval-Augmented Generation 시스템을 쉽게 구성할 수 있습니다

멀티 LLM 지원

멀티 LLM 지원

OpenAI, Claude, Gemini, Llama, Mistral 등 다양한 LLM 및 자체 로컬 모델(Ollama 등)과 연동이 가능하여, 하이브리드 AI 설계에 유리합니다

실시간 디버깅 및 플로우 추적

실시간 디버깅 및 플로우 추적

각 노드별 입출력 데이터를 실시간 확인할 수 있어 빠른 테스트 및 디버깅, 성능 최적화에 용이합니다

[그림] veneta.weave 이용한 AI 구축 화면